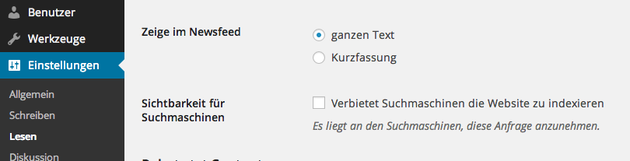

Damit man bei Google auch gefunden wird, ist eine robots.txt-Datei sehr hilfreich. Diese Datei ermöglicht oder verbietet den Suchmaschinen das indexieren der Webseite. Unter Einstellungen / Lesen kann man Auswählen, ob das Indexieren erlaubt ist oder nicht. Bei WordPress wird daraufhin eine virtuelle robots.txt angelegt.

Direkt nach der Installation verbietet man gerne schon mal den Suchmaschinen die Webseite zu indexieren, da noch am Design getestet wird. Will man dann nach Fertigstellung der Webseite die Sitemap (eine Art Organigramm der Webseite) bei Google Webmaster Tools hochladen, erscheint eine Fehlermeldung „robots.txt. verbietet Google das Indexieren“. Da ist natürlich sehr schlecht, schließlich will man ja gerade bei Google gefunden werden. Auch eine manuell hochgeladene robots.txt hilft noch nicht.

Die Lösung:

Ich hatte genau das Problem und habe zusätzlich das Plugin „WP Robots Txt“ installiert (Link zum Plugin: https://wordpress.org/plugins/wp-robots-txt/). Dann habe ich die robot.txt wie im WordPress Forum (Link zum Forum: http://codex.wordpress.org/Search_Engine_Optimization_for_WordPress) angegeben erstellt:

# Google Image # Google AdSense # digg mirror # global

User-agent: Googlebot-Image

Disallow:

Allow: /*

User-agent: Mediapartners-Google

Disallow:

User-agent: duggmirror

Disallow: /

User-agent: *

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/cache/

Disallow: /wp-content/themes/

Disallow: /trackback/

Disallow: /feed/

Disallow: /comments/

Disallow: /category/*/*

Disallow: */trackback/

Disallow: */feed/

Disallow: */comments/

Disallow: /*?

Allow: /wp-content/uploads/

Danach habe ich die Sitemap nochmal im Google Webmaster Tool getestet: Und siehe da! Die Sitemap wurde fehlerfrei ausgelesen.